映像を見て感じたことが言葉になる 脳活動を解読する技術を開発

情報通信研究機構(NICT)は1日、脳の活動から、人が映像を見て感じた印象を読み取ることに成功したと発表。名詞・動詞に加えて形容詞も含めた1万語で解読した。将来、目や耳を使わずに視聴覚情報を脳に直接入力することで、感覚器に傷を負った人の生活のサポートなどに応用できることが期待される。この成果は神経科学の国際科学誌『NeuroImage(ニューロ・イメージ)』オンライン版に掲載された。

NICTは、人が映像を見て感じた印象を脳活動から解読し、これまで対応できていなかった形容詞も含め、従来技術の500単語に比べて20倍の1万単語で解読する脳情報デコーディング技術を開発した。

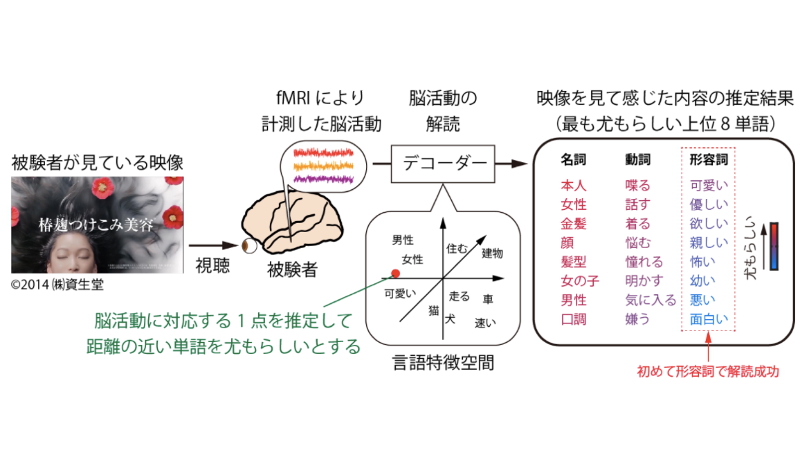

脳情報デコーディングでは、まず被験者に映像を見せ、脳活動に伴う血液の流れや酸素代謝の変化をMRI(磁気共鳴画像装置)で測定。脳活動の場所や強度を推定する。他方で、被験者とは別の人々に対して、被験者と同じ映像の各シーンの説明や感じた内容を言葉で書いてもらう。書いてもらった言語表現は、意味が近いものは近く、意味が遠いものは遠くの1点として表現する「言語特徴空間」上に変換される。例えば、「猫」と「犬」は意味が近いため、各々の点は近い距離に、「猫」と「建物」は意味が遠いため、各々の点は離れた距離に配置される。

さらに、あらかじめ大規模テキストデータから言語特徴空間上に用意した1万語の各点の位置と、被験者の脳活動から推定した点の位置との距離を算出。被験者が見て感じた内容が類似しているかどうかを判断する。これを名詞・動詞・形容詞に対して行い、映像を見た被験者が感じた内容を単語で推定する仕組みだ。今回開発した技術では、この推定のもっともらしさを6人の被験者に対して評価し、高い精度で推定が可能であることを確認したという。

この技術を応用することで、発話や筆談が困難な人が頭の中で考えただけで内容を言語化するなど、言葉を介さないコミュニケーションの実現が期待される。

画像提供:情報通信研究機構